AI Differentiation of Bok Choy Seedlings from Weeds

-

摘要:目的 提出一种基于人工智能的青菜幼苗与杂草识别方法,以期解决杂草识别这一制约精确除草的瓶颈问题。方法 以青菜幼苗及其伴生杂草为试验对象,通过神经网络模型识别青菜幼苗。青菜幼苗目标之外的绿色像素则认为是杂草,并利用颜色特征对杂草进行分割。为探究主流卷积神经网络(Convolutional Neural Networks,CNN)模型以及新兴Transformer神经网络模型在青菜识别中的效果,分别选取YOLOX模型和Deformable DETR模型,以识别率和识别性能作为评价指标进行对比分析。结果 基于CNN的YOLOX模型和基于Transformer的Deformable DETR模型都能有效识别青菜幼苗。其中YOLOX模型为最优模型,平均精度和识别速度分别为98.1%和44.8 fps。结论 将青菜幼苗之外的绿色目标视为杂草的思路不仅简化了杂草识别的复杂性,同时提高了杂草识别的泛化能力。提出的青菜幼苗与杂草识别方法可用于青菜幼苗生长管理的精准作业。

-

关键词:

- 青菜幼苗 /

- 杂草识别 /

- 人工智能 /

- 卷积神经网络 /

- Transformer神经网络

Abstract:Objective An artificial intelligence-based identification method to effectively differentiate bok choy seedlings from weeds was proposed to facilitate vegetable farm weeding operation.Methods Bok choy seedlings were recognized by the neural network models to exclude the green pixels from other vegetations considered as weeds by color differentiation. Effectiveness of the convolutional neural networks (CNN) and the emerging transformer models in correctly separating the seedlings and weeds was evaluated.Result Although both performed acceptable, the YOLOX model delivered a higher average accuracy of 98.1% and a faster speed at 44.8 fps than Deformable DETR in the recognition operation.Conclusion By defining the green pixels of bok choy seedlings as target color, weeds could be rejected by the AI recognition program providing a robust separation for efficient weeding in the field of the random-planting vegetables such as bok choy.-

Keywords:

- Bok choy seedling /

- weed detection /

- artificial intelligence /

- CNN /

- Transformer Neural Network

-

0. 引言

【研究意义】青菜幼苗与杂草的精准识别是实现青菜智能化作业,促进高质量蔬菜生产的关键[1]。目前,青菜田的杂草防除仍然依赖人工除草。人工除草效率低下,且人力成本的提高不仅推高了青菜的种植成本,同时也限制了蔬菜产业的发展[2]。智能化的机械除草是青菜杂草控制的首选方式[3-4],而杂草的精准识别是其实现过程中的关键一环[5-6]。【前人研究进展】近年来,研究人员相继开展了杂草识别研究[7-9]。徐涛等[10]提出了一种基于三维点云的蔬菜大棚杂草识别方法,利用高度特征区分蔬菜作物和杂草,识别率可达86.48%。Osorio等[11]分别基于机器学习的支持向量机(SVM)技术和基于深度学习的YOLO-v3、Mask R-CNN卷积神经网络模型对生菜田中的伴生杂草进行识别,试验结果表明,人工智能技术优于传统图像处理技术,可有效识别杂草。杂草识别方法通常利用杂草本身的特征,包括颜色特征[12]、形态特征[13]、纹理特征[14]和多光谱特征[15]等。杂草种类繁多,特征各异,难以提取具有普适作用的特征,且人工设计的特征存在着精准度差、鲁棒性不足等缺陷[5, 16-18]。随着人工智能技术的发展,机器学习、深度学习等技术逐渐应用于杂草识别研究,并取得了诸多进展[19-22]。【本研究切入点】文献检索显示,青菜幼苗识别国内外尚无相关研究,本文将基于人工智能技术对青菜幼苗识别展开初步探索。在菜田中,青菜之外的植物都可以认为是杂草或者被视作杂草。因此,识别出青菜幼苗后,剩余的绿色目标即可标记为杂草。这一方式不仅简化了杂草识别的复杂性,同时提高了杂草识别的泛化能力。对于不同种类、形态、生长状况的杂草都能基于识别青菜,进而通过颜色特征进行杂草的识别和分割。【拟解决的关键问题】本文拟提出并验证适用于当前青菜无行距和株距种植方式的青菜幼苗与杂草识别方法,以期解决杂草识别这一制约精确除草的瓶颈问题,同时为青菜及其他相似蔬菜的精准作业提供技术参考。

1. 材料与方法

1.1 图像采集

以青菜幼苗及其伴生杂草为试验对象。青菜幼苗图像于2020年7月和9月分2批采集自南京市栖霞区八卦洲的某青菜种植园内,图像原始分辨率为4032 × 3024像素,共采集图像样本850幅。为保证神经网络模型训练样本的多样性,图像采集了不同播种时间的青菜田,以及晴天、阴天等不同光线状态下的样本实体。为降低图像处理时间,提高算法田间应用的实时性,对于采集的样本图像,使用开源图像处理软件ImageJ(https://imagej.nih.gov/ij/)批量调整尺寸至1400 × 1050像素,并使用LabelImg软件进行图像标注,标注信息为青菜幼苗的矩形边框,标注完成后生成与图像对应的XML标签文件,作为神经网络模型的数据集样本。

1.2 神经网络框架

为探究不同神经网络模型对青菜幼苗识别的效果,选取不同目标检测模型进行评价分析。试验神经网络平台为MMDetection框架。MMDetection是一款基于PyTorch的开源工具箱,其支持了众多主流的神经网络模型算法。神经网络模型训练和运行的硬件系统为台式计算机,搭载Inter(R) core(TM) i9-9900K CPU @3.60 GHZ处理器,图形处理单元为NVIDIA GeForce RTX 2080Ti,运行内存为64 GB,操作系统为Ubuntu 20.04。

1.3 青菜幼苗与杂草识别方法

将采集到的青菜幼苗图像分为训练集、验证集和测试集。训练集图像用于神经网络模型的训练,并基于验证集评价数据获取最优训练模型。同时,对比不同置信度阈值下的精度、召回率和F1值,选择最佳置信度阈值应用于测试集。根据测试集评价数据,对比分析CNN模型和Transformer模型的检测效果。将所得最优神经网络模型用于青菜幼苗的识别。识别出青菜幼苗后,边框之外的绿色目标即视为杂草,进而利用颜色特征进行杂草分割,并通过面积滤波滤除分割噪点。

1.3.1 基于人工智能的青菜幼苗识别

1.3.1.1 检测模型

当前目标检测算法主要基于卷积神经网络(CNN),其中最具代表性的为YOLO系列模型。YOLO模型利用多尺度检测和残差网络实现目标检测,同时通过将目标检测转化为端到端的回归问题,极大地提高了检测性能。YOLO模型兼具高准确率和实时目标检测能力[23]。得益于强大的注意力机制,基于Transformer的神经网络模型广泛应用于自然语言处理(NLP)任务,成为了NLP领域的主流算法。近年来,研究者将Transformer应用至计算机视觉领域,结果表明其在目标检测任务中展现了优异的性能,亦逐渐成为当下的研究热点。

为探究主流CNN模型以及新兴Transformer模型在青菜幼苗识别中的效果,并为相似植物检测领域神经网络模型的选取方式提供参考,本研究分别选取基于CNN的最新一代YOLO系列模型YOLOX和基于Transformer机制的Deformable DETR模型开展试验。在田间应用中,算法的实时性至关重要。本研究将从检测准确率和检测性能两方面对CNN模型和Transformer模型进行综合对比,并根据评价结果选取最佳模型进行青菜幼苗识别试验。表1为模型的超参设置。

表 1 模型超参设置Table 1. Hyperparameters of models模型

Model批尺寸

Batch初始学习率

Initial learning

rate优化器

Optimizer衰减值

Decay训练周期

Training epochsYOLOX 4 0.01 SGD 5e-4 300 Deformable DETR 1 2e-4 AdamW 0.0001 120 1.3.1.2 评价指标

采用精度(precision)、召回率(recall)、F1值以及平均精度(average precision)作为模型的评价指标。其中,精度表示模型正确检测出的青菜幼苗数量与预测为青菜幼苗数量的比值。召回率则表示样本中所有青菜幼苗目标被正确预测的比例。精度和召回率的计算公式为:

precision=tptp+fp (1) recall=tptp+fn (2) 式中tp为被模型预测为正的正样本数量、fp为被模型预测为正的负样本数量、fn为被模型预测为负的正样本数量。

F1值是基于精度和召回率的综合评价指标,其定义为精度与召回率的调和平均数:

F1=2×precision×recallprecision+recall (3) 平均精度表示模型对某一类别目标的检测效果,由于本研究只有青菜幼苗一个类别,因而平均精度越高,表明模型总体检测效果越佳。平均精度的计算方式为取精度和召回率曲线(PR-Curve)的积分:

AP=∫10P(R)dR (4) 1.3.2 基于颜色特征的杂草识别

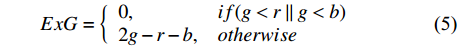

杂草与青菜幼苗同为绿色,单纯利用颜色特征很难进行区分。但另一方面,杂草与土壤背景的颜色存在较大差异,通过绿色特征可以从土壤中识别出杂草。本研究首先利用人工智能识别出青菜幼苗,并在识别杂草时去除青菜幼苗边框之内的像素。如此,图像中剩下的绿色像素值即可认为是杂草像素,利用颜色特征将其从土壤背景中分割出来。本研究采用杂草识别中广泛应用的超绿因子[24]对杂草进行分割。杂草为绿色,因而对于RGB颜色空间下的杂草像素,其G分量值必然大于R分量值和B分量值。根据此规律,可对超绿因子进行条件改进,以进一步提高分割性能。改进后的超绿因子如下所示:

ExG={0,if(g<r∥g<b)2g−r−b,otherwise (5) 式中,R、G、B分别为对应RGB值,r、g、b分别为归一化之后的RGB值,采用归一化之后的像素值可以在一定程度降低光照强度对图像分割的影响[25]。r、g、b的计算公式为:

r=RR+G+B,g=GR+G+B,b=BR+G+B (6) 2. 结果与分析

2.1 青菜幼苗识别

青菜幼苗识别样本数据集共有850张图像,其中训练集为650张图像、验证集和测试集各包含100张图像。训练集、验证集和测试集样本相互独立无交叉。数据集标注青菜幼苗目标10578个,其中训练集、验证集和测试集分别包含7911个、1320个以及1347个青菜幼苗。模型在检测过程中根据置信度判定当前预测目标是否为正样本,因而置信度阈值的选取关乎模型的精度和召回率等评价数据。不同置信度阈值(0.9、0.8、0.7、0.6、0.5、0.4、0.3、0.2和0.1)对应的精度、召回率及F1值数据如表2所示。本研究将在验证集中,根据不同置信度阈值的评价数据,选择最佳阈值用于对比分析测试集下模型的青菜幼苗识别效果。

表 2 不同置信度阈值验证集评价数据Table 2. Evaluation matrixes of varied confidence scores on val data set模型

Model置信度

Confidence score精度

Precision召回率

RecallF1值

F1 scoreYOLOX 0.9 1.000 0.04 0.077 0.8 0.993 0.80 0.886 0.7 0.980 0.93 0.954 0.6 0.953 0.97 0.961 0.5 0.940 0.98 0.959 0.4 0.922 0.99 0.955 0.3 0.922 0.99 0.955 0.2 0.877 1.00 0.934 0.1 0.877 1.00 0.934 Deformable DETR 0.9 0.998 0.54 0.701 0.8 0.991 0.77 0.867 0.7 0.981 0.86 0.917 0.6 0.978 0.90 0.938 0.5 0.963 0.94 0.951 0.4 0.958 0.96 0.959 0.3 0.930 0.98 0.954 0.2 0.893 0.99 0.939 0.1 0.893 0.99 0.939 由表2可知,当置信度阈值为0.9时,YOLOX模型的精度值最高,达到1.0,但对应的召回率只有0.04。该阈值下,虽然YOLOX模型预测的青菜幼苗目标全部正确,但遗漏了96%的青菜幼苗目标。相反,当置信度阈值为0.1和0.2时,YOLOX模型的召回率同样达到了最高值1.0,精度值为0.877,显示其有12.3%的误检。通过观察F1值可知,YOLOX模型和Deformable DETR模型的最佳置信度阈值为0.6和0.4,该置信度下精度值和召回率取得了最佳平衡。分别对应F1值为0.961和0.959。

将最佳置信度阈值应用于测试集,得到表3所示的模型评价数据。观察表3可知,YOLOX模型和Deformable DETR的召回率相同,都高达0.97。召回率是青菜幼苗识别和杂草识别的重要指标,召回率过低会导致青菜幼苗被遗漏进而被误识别为杂草。本研究所选模型表现出了优异的青菜幼苗召回能力。精度方面,YOLOX模型比Deformable DETR模型略高1.5%。由此,YOLOX模型拥有最高的F1值(0.956)。对于平均精度,YOLOX模型和Deformable DETR模型都高于97%,表明其对于青菜幼苗都有较好的识别率。根据F1值和平均精度,YOLOX模型识别青菜幼苗的效果更佳。此结果也表明,卷积神经网络的模型在植物类别检测中仍然比Transformer模型略胜一筹,但差距并不明显,相信随着Transformer模型研究的进一步深入,未来表现可期。

表 3 测试集最优置信度阈值的评价数据Table 3. Evaluation matrix of highest confidence score on test data set模型

Model置信度

Confidence score精度

Precision召回率

RecallF1值

F1 score平均精度

Average precision检测速度

Detection speed / fpsYOLOX 0.6 0.943 0.97 0.956 0.981 44.8 Deformable DETR 0.4 0.928 0.97 0.948 0.972 10.2 表3同样列出了YOLOX模型和Deformable DETR模型的检测速度。该速度值取测试集中100张图像的平均值。观察可知,YOLOX模型和Deformable DETR模型检测性能差距明显,前者的速度是后者的4倍。此结果与YOLOX模型兼顾精度和性能的特征相符。综合识别率和模型检测性能,基于卷积神经网络的YOLOX模型为青菜幼苗识别的最优模型。

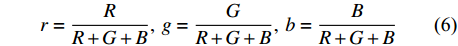

图1所示为评价最优模型YOLOX的青菜幼苗识别效果图。为验证模型在不同场景下的识别鲁棒性,分别选取图1-a包含禾本科杂草的图像、图1-b包含阔叶草的图像以及图1-c不同生长大小的青菜幼苗图像,从效果图可看出,YOLOX模型在不同类型杂草背景和不同青菜幼苗生长大小下,均能正确识别青菜幼苗目标,展示了其良好的识别效果。

青菜种植通常没有明显行距与株距,随机分布于田间,青菜幼苗可能会相互重叠。在该场景下,模型会将两颗或多颗青菜幼苗识别成一颗。此漏检情况虽然会降低识别的召回率,但不会对田间实际应用产生实质影响。在精确除草作业下,重叠青菜幼苗所在的整体区域是被成功识别并标记边框的,并不影响边框之外的绿色目标被判定为杂草。当然,后续可通过增加重叠青菜幼苗的训练样本,以改善此漏检情况。

2.2 杂草识别

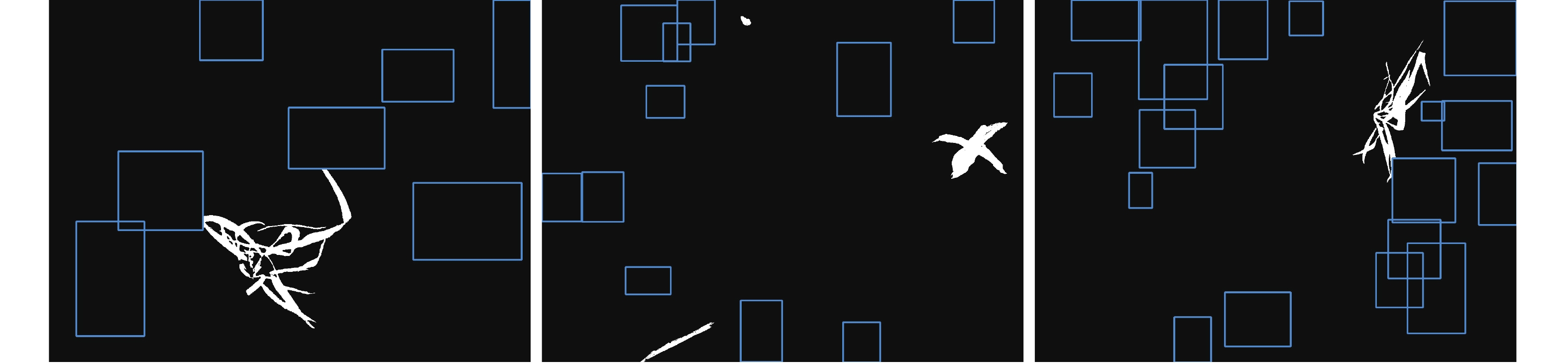

识别并标记青菜幼苗所属绿色像素后,剩余的绿色目标都是杂草或者被看做杂草。图2所示为改进后的超绿因子的杂草分割效果图(去除青菜幼苗边框内绿色像素)。从图中可以看出,杂草被正确识别并展现出极佳的分割效果,但分割后的二值图中仍然存在一些噪点像素。

图3所示为面积滤波之后的分割效果图。观察可见,图中的噪点像素被完全滤除,杂草目标的形态完整且保有清晰的轮廓。图中同样用蓝色矩形框标记出青菜幼苗的位置,根据此效果图的青菜幼苗和杂草识别信息,可用于田间青菜幼苗的精准除草工作。该试验结果表明本研究所提出的青菜幼苗和杂草识别方法具有高度的可行性以及极佳的应用前景。

青菜生长周期较短,播种后18~25 d 即可收获[26]。除草工作通常在青菜幼苗期进行。本研究不直接识别杂草,而是通过识别青菜幼苗进而间接识别杂草。因此,杂草种类、形态和大小的差异并不会实质影响杂草识别的效果。

3. 讨论与结论

本研究提出了一种基于人工智能的青菜幼苗与杂草识别方法。首先通过神经网络模型识别青菜幼苗。青菜幼苗目标之外的绿色像素则视为杂草,并利用颜色特征对杂草进行分割。研究所得结论如下:

1) 主流的CNN模型YOLOX和新兴的Transformer模型Deformable DETR都能有效识别青菜幼苗。其中YOLOX模型为本次青菜幼苗识别试验的最优模型,其平均精度和识别速度分别为98.1%和44.8 fps。

2) 识别并标记青菜幼苗目标后,图像中剩余的绿色目标都是杂草或者被看做杂草。此方式不仅简化了杂草识别的复杂性,同时提高了杂草识别的泛化能力。试验表明,该方法能够有效识别杂草,适用于当前青菜无行距和株距的种植方式。

-

表 1 模型超参设置

Table 1 Hyperparameters of models

模型

Model批尺寸

Batch初始学习率

Initial learning

rate优化器

Optimizer衰减值

Decay训练周期

Training epochsYOLOX 4 0.01 SGD 5e-4 300 Deformable DETR 1 2e-4 AdamW 0.0001 120 表 2 不同置信度阈值验证集评价数据

Table 2 Evaluation matrixes of varied confidence scores on val data set

模型

Model置信度

Confidence score精度

Precision召回率

RecallF1值

F1 scoreYOLOX 0.9 1.000 0.04 0.077 0.8 0.993 0.80 0.886 0.7 0.980 0.93 0.954 0.6 0.953 0.97 0.961 0.5 0.940 0.98 0.959 0.4 0.922 0.99 0.955 0.3 0.922 0.99 0.955 0.2 0.877 1.00 0.934 0.1 0.877 1.00 0.934 Deformable DETR 0.9 0.998 0.54 0.701 0.8 0.991 0.77 0.867 0.7 0.981 0.86 0.917 0.6 0.978 0.90 0.938 0.5 0.963 0.94 0.951 0.4 0.958 0.96 0.959 0.3 0.930 0.98 0.954 0.2 0.893 0.99 0.939 0.1 0.893 0.99 0.939 表 3 测试集最优置信度阈值的评价数据

Table 3 Evaluation matrix of highest confidence score on test data set

模型

Model置信度

Confidence score精度

Precision召回率

RecallF1值

F1 score平均精度

Average precision检测速度

Detection speed / fpsYOLOX 0.6 0.943 0.97 0.956 0.981 44.8 Deformable DETR 0.4 0.928 0.97 0.948 0.972 10.2 -

[1] 陈桂芬, 马丽, 陈航. 精准施肥技术的研究现状与发展趋势 [J]. 吉林农业大学学报, 2013, 35(3):253−259. CHEN G F, MA L, CHEN H. Research status and development trend of precision fertilization technology [J]. Journal of Jilin Agricultural University, 2013, 35(3): 253−259.(in Chinese)

[2] LANINI W T, STRANGE M L. Low-input management of weeds in vegetable fields [J]. California Agriculture, 1991, 45(1): 11−13. DOI: 10.3733/ca.v045n01p11

[3] 金月, 肖宏儒, 曹光乔, 等. 我国叶类蔬菜机械化水平现状与评价方法研究 [J]. 中国农机化学报, 2020, 41(12):196−201. JIN Y, XIAO H R, CAO G Q, et al. Research on status and evaluation methods of leafy vegetable mechanization production level in China [J]. Journal of Chinese Agricultural Mechanization, 2020, 41(12): 196−201.(in Chinese)

[4] 洪晓玮, 陈勇, 杨超淞, 等. 有机蔬菜大棚除草机器人研制 [J]. 制造业自动化, 2021, 43(5):33−36, 71. DOI: 10.3969/j.issn.1009-0134.2021.05.008 HONG X W, CHEN Y, YANG C S, et al. Development of a weeding robot for organic vegetable greenhouse [J]. Manufacturing Automation, 2021, 43(5): 33−36, 71.(in Chinese) DOI: 10.3969/j.issn.1009-0134.2021.05.008

[5] 金小俊, 陈勇, 孙艳霞. 农田杂草识别方法研究进展 [J]. 农机化研究, 2011, 33(7):23−27, 33. DOI: 10.3969/j.issn.1003-188X.2011.07.005 JIN X J, CHEN Y, SUN Y X. Research advances of weed identification in agricultural fields [J]. Journal of Agricultural Mechanization Research, 2011, 33(7): 23−27, 33.(in Chinese) DOI: 10.3969/j.issn.1003-188X.2011.07.005

[6] 毛文华, 张银桥, 王辉, 等. 杂草信息实时获取技术与设备研究进展 [J]. 农业机械学报, 2013, 44(1):190−195. DOI: 10.6041/j.issn.1000-1298.2013.01.036 MAO W H, ZHANG Y Q, WANG H, et al. Advance techniques and equipments for real-time weed detection [J]. Transactions of the Chinese Society for Agricultural Machinery, 2013, 44(1): 190−195.(in Chinese) DOI: 10.6041/j.issn.1000-1298.2013.01.036

[7] 王璨, 武新慧, 张燕青, 等. 基于双注意力语义分割网络的田间苗期玉米识别与分割 [J]. 农业工程学报, 2021, 37(9):211−221. DOI: 10.11975/j.issn.1002-6819.2021.09.024 WANG C, WU X H, ZHANG Y Q, et al. Recognition and segmentation of maize seedlings in field based on dual attention semantic segmentation network [J]. Transactions of the Chinese Society of Agricultural Engineering, 2021, 37(9): 211−221.(in Chinese) DOI: 10.11975/j.issn.1002-6819.2021.09.024

[8] 樊湘鹏, 周建平, 许燕, 等. 基于优化faster R-CNN的棉花苗期杂草识别与定位 [J]. 农业机械学报, 2021, 52(5):26−34. DOI: 10.6041/j.issn.1000-1298.2021.05.003 FAN X P, ZHOU J P, XU Y, et al. Identification and localization of weeds based on optimized faster R-CNN in cotton seedling stage [J]. Transactions of the Chinese Society for Agricultural Machinery, 2021, 52(5): 26−34.(in Chinese) DOI: 10.6041/j.issn.1000-1298.2021.05.003

[9] 许燕, 温德圣, 周建平, 等. 基于faster R-CNN的新疆棉花幼苗与杂草识别方法 [J]. 排灌机械工程学报, 2021, 39(6):602−607. XU Y, WEN D S, ZHOU J P, et al. Identification method of cotton seedlings and weeds in Xinjiang based on faster R-CNN [J]. Journal of Drainage and Irrigation Machinery Engineering, 2021, 39(6): 602−607.(in Chinese)

[10] 徐涛, 陈勇, 周卫鹏. 基于三维点云的蔬菜大棚杂草识别方法 [J]. 北方园艺, 2021(2):153−158. XU T, CHEN Y, ZHOU W P. A weed identification method in vegetable greenhouses based on three-dimensional point cloud [J]. Northern Horticulture, 2021(2): 153−158.(in Chinese)

[11] OSORIO K, PUERTO A, PEDRAZA C, et al. A deep learning approach for weed detection in lettuce crops using multispectral images [J]. AgriEngineering, 2020, 2(3): 471−488. DOI: 10.3390/agriengineering2030032

[12] TANG L, TIAN L, STEWARD B L. Color image segmentation with genetic algorithm for in-field weed sensing [J]. Transactions of the ASAE, 2000, 43(4): 1019−1027. DOI: 10.13031/2013.2970

[13] HERRERA P, DORADO J, RIBEIRO Á. A novel approach for weed type classification based on shape descriptors and a fuzzy decision-making method [J]. Sensors, 2014, 14(8): 15304−15324. DOI: 10.3390/s140815304

[14] BAKHSHIPOUR A, JAFARI A, NASSIRI S M, et al. Weed segmentation using texture features extracted from wavelet sub-images [J]. Biosystems Engineering, 2017, 157: 1−12. DOI: 10.1016/j.biosystemseng.2017.02.002

[15] JIANG H Z, JIANG X S, RU Y, et al. Application of hyperspectral imaging for detecting and visualizing leaf lard adulteration in minced pork [J]. Infrared Physics & Technology, 2020, 110: 103467.

[16] 仇裕淇, 黄振楠, 阮昭, 等. 机器视觉技术在农业生产智能化中的应用综述 [J]. 机械研究与应用, 2019, 32(2):202−206. QIU Y Q, HUANG Z N, RUAN Z, et al. Review on application of machine vision in intelligent agricultural production [J]. Mechanical Research & Application, 2019, 32(2): 202−206.(in Chinese)

[17] LIAKOS K, BUSATO P, MOSHOU D, et al. Machine learning in agriculture: A review [J]. Sensors, 2018, 18(8): 2674. DOI: 10.3390/s18082674

[18] WANG A C, ZHANG W, WEI X H. A review on weed detection using ground-based machine vision and image processing techniques [J]. Computers and Electronics in Agriculture, 2019, 158: 226−240. DOI: 10.1016/j.compag.2019.02.005

[19] SHI J H, LI Z Y, ZHU T T, et al. Defect detection of industry wood veneer based on NAS and multi-channel mask R-CNN [J]. Sensors, 2020, 20(16): 4398. DOI: 10.3390/s20164398

[20] 邓向武, 马旭, 齐龙, 等. 基于卷积神经网络与迁移学习的稻田苗期杂草识别 [J]. 农机化研究, 2021, 43(10):167−171. DOI: 10.3969/j.issn.1003-188X.2021.10.030 DENG X W, MA X, QI L, et al. Recognition of weeds at seedling stage in paddy fields using convolutional neural network and transfer learning [J]. Journal of Agricultural Mechanization Research, 2021, 43(10): 167−171.(in Chinese) DOI: 10.3969/j.issn.1003-188X.2021.10.030

[21] YU J L, SCHUMANN A W, SHARPE S M, et al. Detection of grassy weeds in bermudagrass with deep convolutional neural networks [J]. Weed Science, 2020, 68(5): 545−552. DOI: 10.1017/wsc.2020.46

[22] HASAN A S M M, SOHEL F, DIEPEVEEN D, et al. A survey of deep learning techniques for weed detection from images [J]. Computers and Electronics in Agriculture, 2021, 184: 106067. DOI: 10.1016/j.compag.2021.106067

[23] 刘天真, 滕桂法, 苑迎春, 等. 基于改进YOLO v3的自然场景下冬枣果实识别方法 [J]. 农业机械学报, 2021, 52(5):17−25. DOI: 10.6041/j.issn.1000-1298.2021.05.002 LIU T Z, TENG G F, YUAN Y C, et al. Winter jujube fruit recognition method based on improved YOLO v3 under natural scene [J]. Transactions of the Chinese Society for Agricultural Machinery, 2021, 52(5): 17−25.(in Chinese) DOI: 10.6041/j.issn.1000-1298.2021.05.002

[24] WOEBBECKE D M, MEYER G E, BARGEN K V, et al. Color indices for weed identification under various soil, residue, and lighting conditions [J]. Transactions of the ASAE, 1995, 38(1): 259−269. DOI: 10.13031/2013.27838

[25] GÉE C, BOSSU J, JONES G, et al. Crop/weed discrimination in perspective agronomic images [J]. Computers and Electronics in Agriculture, 2008, 60(1): 49−59. DOI: 10.1016/j.compag.2007.06.003

[26] 刘东, 肖宏儒, 金月, 等. 基于ANSYS的鸡毛菜茎秆切割的有限元分析及验证试验 [J]. 中国农业科技导报, 2018, 20(11):85−93. LIU D, XIAO H R, JIN Y, et al. Finite element analysis of stalk cutting of Chinese little greens based on ANSYS and verification test [J]. Journal of Agricultural Science and Technology, 2018, 20(11): 85−93.(in Chinese)

-

期刊类型引用(4)

1. 冀汶莉,刘洲,邢海花. 基于YOLO v5的农田杂草识别轻量化方法研究. 农业机械学报. 2024(01): 212-222+293 .  百度学术

百度学术

2. 李卫丽,金小俊,于佳琳,陈勇. 基于深度学习的蔬菜田精准除草作业区域检测方法. 福建农业学报. 2024(02): 199-205 .  本站查看

本站查看

3. 金慧萍,牟海雯,刘腾,于佳琳,金小俊. 基于深度卷积神经网络的青菜和杂草识别. 中国农业科技导报. 2024(08): 122-130 .  百度学术

百度学术

4. 钟斌,杨珺,刘毅,任锦涛. 基于改进DINO的牧场杂草检测. 河南农业科学. 2023(09): 156-163 .  百度学术

百度学术

其他类型引用(10)

下载:

下载: